El auge de la IA está desdibujando la línea entre realidad y ficción a un ritmo preocupante. Así lo vivió en carne propia una pareja de ancianos de Kuala Lumpur, Malasia, que condujo más de 350 kilómetros para visitar una idílica atracción turística llamada Kuak Skyride, un teleférico panorámico supuestamente ubicado en el tranquilo pueblo de Kuak Hulu, en el estado malayo de Perak.

Solo había un problema: tal atracción nunca ha existido.

Todo comenzó cuando vieron un vídeo en redes sociales, difundido por un canal virtual llamado TV Rakyat. En él, una presentadora «visitaba» un teleférico que recorría frondosos bosques tropicales.

Para los ojos poco entrenados, era un reportaje turístico perfectamente creíble, pero todo el contenido había sido generado mediante inteligencia artificial —específicamente, con la herramienta Veo3 de Google.

Del entusiasmo a la decepción

Conmovidos por la belleza del video y convencidos de la autenticidad de lo mostrado, la pareja decidió irse allí de vacaciones: reservaron hotel, emprendieron el viaje en coche, y… al llegar y preguntar en recepción por el teleférico, el personal pensó que se trataba de una broma.

A pesar de los intentos de los empleados por explicar la situación, en un primer momento los turistas insistieron en que el vídeo parecía auténtico.

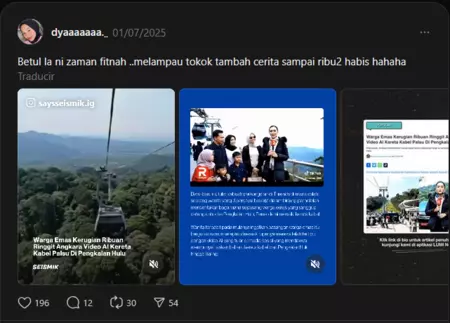

La recepcionista del hotel ha recopilado en Threads los vídeos de la polémica

«¿Por qué le hacen esto a la gente? […] El vídeo parecía una noticia real», dijo la anciana, quien incluso llegó a plantearse demandar a la periodista del reportaje antes de que le explicaran que ella también era un personaje ficticio creado con IA.

Distorsión de la realidad

Muchos usuarios se han preguntado en redes cómo los protagonistas de la historia pudieron dejarse engañar por algo tan claramente ficticio (el vídeo mostraba el logotipo de Veo3 en la esquina inferior).

Pero aunque la historia puede parecer motivo de mofa, plantea una cuestión grave: cuán fácilmente se puede confundir un contenido generado con IA con uno real, sobre todo por parte de personas mayores o no familiarizadas con estas tecnologías.

Según la firma de seguridad digital Signicat, los fraudes basados en deepfakes han aumentado un 2.137% en los últimos tres años, pasando de representar el 0,1% a más del 6% de los intentos de estafa. Incluso si el caso de los ancianos malayos no implicó pérdidas económicas significativas, resulta todo un síntoma sobre cuán distorsionada está a estas alturas la percepción del mundo real.

El turismo deepfake

El turismo ya había sido moldeado por la estética artificial mucho antes de que la IA perfeccionara el engaño. La ‘instagramificación’ de los viajes —en la que los destinos se visitan más por sus posibilidades fotográficas que por su valor cultural— ha alterado los hábitos de millones de usuarios.

Ahora, con la IA generativa, se introduce un nuevo nivel de simulación: lugares enteramente fabricados que inducen al turista a desplazarse hacia la nada. Ante esta nueva realidad, urge conocer algunas recomendaciones para evitar caer en trampas similares:

- Verificar la autenticidad de videos turísticos, buscando información al respecto en fuentes oficiales de turismo o medios acreditados.

- Observar señales digitales como marcas de agua, logos de herramientas de IA (como Veo3) o inconsistencias visuales.

- En general, no confiar ciegamente en redes sociales como fuente única de información.

Imagen | Marcos Merino mediante IA

–

La noticia

Ya está aquí el ‘turismo deepfake’: una pareja termina visitando una atracción inexistente tras verla en un vídeo generado con IA

fue publicada originalmente en

Genbeta

por

Marcos Merino

.