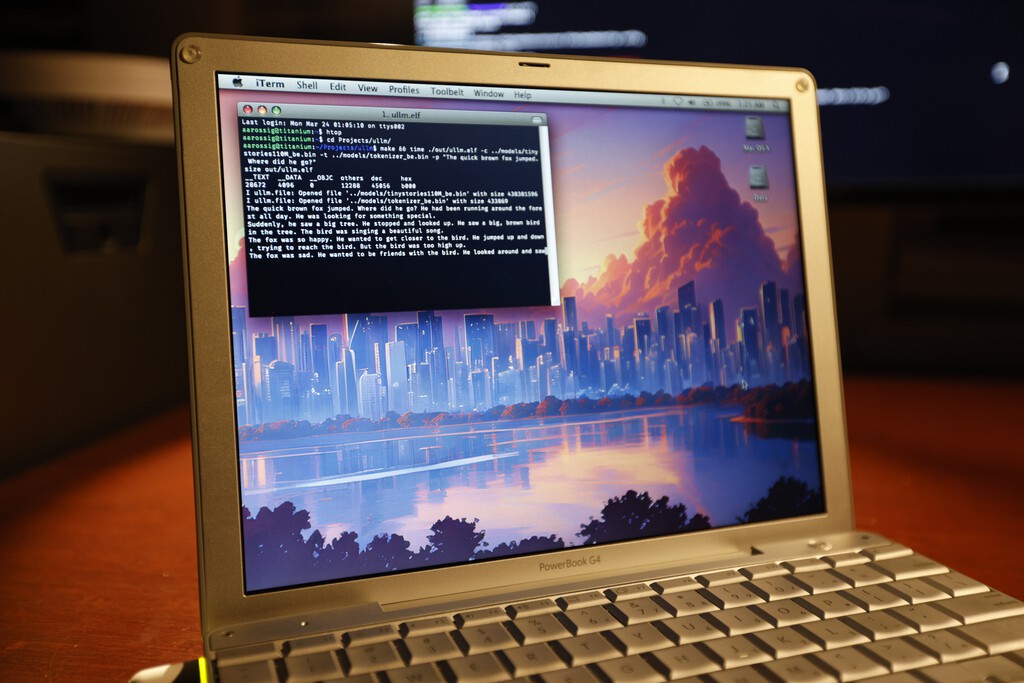

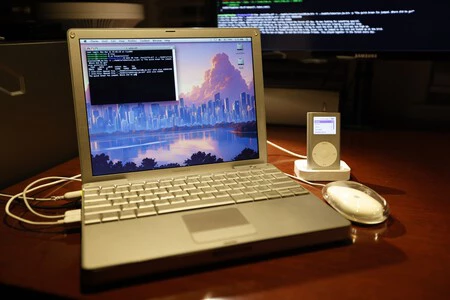

Un usuario entusiasta ha querido hacer uso de su PowerBook G4 del año 2005 para probar si el sistema es capaz de asimilar y procesar un modelo de lenguaje como Llama 2. Generalmente, utilizar un modelo de lenguaje en local es una tarea que requiere de un equipo decente para que el sistema se mueva con soltura.

Para la tarea, Andrew Rossignol, autor del blog ‘The Resistor Network‘, partió de la eficaz implementación de Llama 2 de Andrej Kaparthy, modificada para dar simplicidad y accesibilidad a este modelo de lenguaje en un amplio abanico de sistemas. De hecho, este fue el mismo código que se usó para ejecutar el LLM (Large Language Model) en un PC con Windows con solo 128 MB de RAM.

Así se ejecuta una IA en local en un equipo de hace 20 años

El PowerBook utilizado para la prueba cuenta con un procesador de 1,5 GHz, apenas 1 GB de RAM y una arquitectura de 32 bits. El proyecto se basa en la adaptación del código de Kaparthy, que permite la inferencia del modelo de Llama 2 a través de un único archivo escrito en C. El autor expresa en el texto la satisfacción del reto que supone llevar esta tecnología a un entorno con recursos muy limitados .

El usuario demostró cómo a través de una serie de modificaciones en el código de Kaparthy, pudo completar la tarea de ejecutar un modelo de lenguaje de la talla de Llama 2 en un sistema tan limitado hoy día como el PowerBook G4 de Apple. El secreto fue la optimización del código y la tecnología presente en el procesador de este ordenador.

Imagen: Andrew Rossignol (The Resistor Network)

Para superar los obstáculos propios de las limitaciones en el hardware, el autor realizó diversas optimizaciones en el código. Entre ellas, se incluyen ajustes para mejorar la gestión de recursos, como la abstracción de las funciones de entrada/salida y la gestión de memoria, así como la incorporación de un sistema basado en “callbacks” que facilita la visualización de los resultados a medida que se generan. Esta estructura modular permite además realizar pruebas de funcionamiento sin depender de salidas de texto directas, lo que garantiza que el modelo responde correctamente a diferentes entradas.

Uno de los mayores retos de portar este software a un PowerBook G4 reside en la diferencia de arquitectura. Mientras que la implementación original asume un entorno de ‘endian’ pequeño (little-endian), el procesador PowerPC utiliza el formato ‘big-endian’. El término ‘endian‘ se refiere al orden en que se almacenan los bytes en la memoria. En un sistema big-endian, como el PowerPC, los bytes más significativos de un número se almacenan primero, mientras que en un sistema little-endian, los bytes menos significativos van primero.

Para resolver este conflicto, se implementó un mecanismo de conversión de datos que reinterpreta correctamente los números almacenados, evitando así errores críticos en la asignación de memoria.

Además, el autor aprovechó las capacidades del procesador, en concreto las extensiones vectoriales AltiVec, que permiten realizar operaciones matemáticas de forma más rápida y eficiente. Mediante el uso de estas instrucciones especiales, el usuario optimizó los cálculos fundamentales de multiplicación y suma que forman el núcleo del procesamiento del modelo, consiguiendo reducir significativamente los tiempos de respuesta, aunque sigue siendo más lento si se compara con equipos modernos.

Para medir el rendimiento, se realizaron pruebas tanto en un sistema actual como en el PowerBook G4. Mientras que en un procesador moderno se alcanzaron alrededor de 6,91 tokens por segundo, en el antiguo portátil la tasa se redujo notablemente, con resultados cercanos a 0,77 tokens por segundo. Tras aplicar las optimizaciones con AltiVec, el rendimiento mejoró ligeramente.

Tal y como aporta el usuario, el experimento resulta en otra increíble muestra de cómo un modelo de lenguaje se puede usar incluso en equipos mucho más modestos, aunque el rendimiento no sea el ideal. Eso sí, para ello hay que poner un esfuerzo significativo en implementar las optimizaciones necesarias. Este tipo de proyectos son esperanzadores en tanto que permiten democratizar el uso de la IA sin necesidad de que se deba usar estrictamente un modelo subido a la nube.

Imagen de portada | Andrew Rossignol (The Resistor Network)

–

La noticia

Demuestran que solo se necesita un Mac de hace 20 años con 1 GB de RAM para ejecutar una potente IA. El secreto está en su CPU

fue publicada originalmente en

Genbeta

por

Antonio Vallejo

.